IT之家 5 月 26 最近,微软宣布了其小语言 AI 模型家族(SLM)最新成员“Phi-3-vision该模型以“视觉能力”为主,能理解图文内容,同时据说能在移动平台上流畅高效地运行。

据介绍,Phi-3-vision 是微软 Phi-3 家族第一个多模态模型,基于这个模型的文本理解能力 Phi-3-mini,同时也具备 Phi-3-mini 轻量级的特点,能够在移动平台上 / 嵌入终端运行;模型参数为 42 亿,大于 Phi-3-mini(3.8B),但小于 Phi-3-small(7B)上下文长度为 128k token,训练期间为 2024 年 2 月至 4 月。

IT之家注意到,Phi-3-vision 模型最大的特点就像它的名字一样,主要支持“图形识别能力”,声称能够理解现实世界的图片含义,快速识别和提取图片中的文本。

微软表示,Phi-3-vision 特别适用于办公场合,开发人员在识别图表和方块图时特别优化了该模型 (Block diagram) 据说,理解能力可以利用用户输入的信息进行推论,同时也可以得出一系列结论,为企业提供战略建议,被称为“效果与大模型相当”。

在模型训练方面,微软声称 Phi-3-vision 它由“各种类型的图片和文本数据培训”组成,包括一系列“严格选择的公共内容”,如“教科书等级”教育材料、代码、图形标记数据、现实世界知识、图表图片、聊天格式等,以确保模型输入内容的多样性。微软声称,他们使用的训练数据“可追溯性”不包含任何个人信息,以确保隐私。

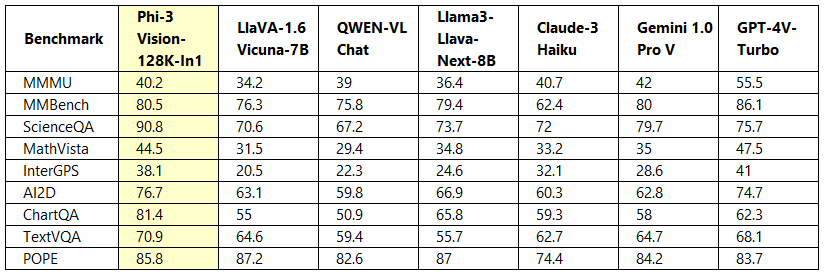

在性能方面,微软提供 Phi-3-vision 与字节跳动相比 Llama3-Llava-Next(8B)、微软研究所与威斯康星大学和哥伦比亚大学合作 LlaVA-1.6(7B)、阿里巴巴通义千问 QWEN-VL-Chat 比较模型等竞争模型的图表,其中显示 Phi-3-vision 模型在多个项目中表现出色。

目前,微软已上传到该模型 Hugging Face,感兴趣的朋友可以访问项目地址:点击此进入

相关阅读:

英特尔力押 SLM 小语言 AI 该模型宣布其软硬件已适应微软 Phi-3》

广告声明:文本中包含的外部跳转链接(包括不限于超链接、二维码、密码等形式)用于传递更多信息,节省选择时间。结果仅供参考。IT之家的所有文章都包括本声明。