近日,东北师范大学徐海阳教授团队研发出一款仿生自适应光传感器。在自供电模式之下,它能感知并处理从紫外到近红外宽波段的入射光,并能很好地模拟人眼的视觉适应行为。

这项成果既丰富了当前神经形态器件的种类,也促进了视网膜仿生器件的发展,有望成为仿生视觉系统中感知端的重要集成组件,从而推动仿生视觉领域的进一步发展。

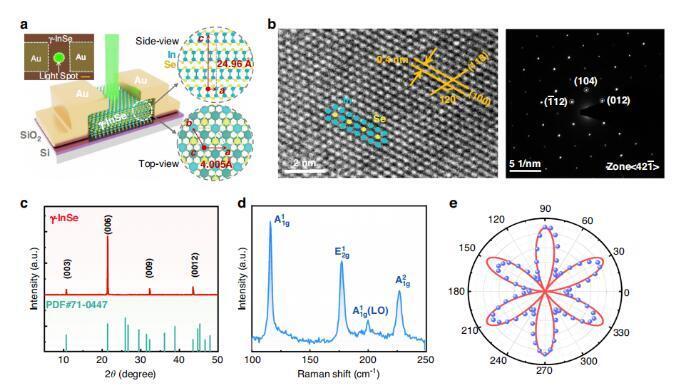

据了解,该传感器基于二维 γ-InSe 半导体材料,采用 “非中心对称”和“非对称接触”的设计思路,背后机制结合了光-热释电效应、以及光-热电效应,即基于以“光-热-电”作用为基础的工作机制。

通过此,它可以对光强和波长进行分辨,从而产生自适应的光响应。

目前,在自驱动模式之下,其已具备模拟部分人眼适应功能的能力。

也就是说,本传感器可以在不同光照情境之下,进行按需生产与应用,比如用于智能监控、自动驾驶、机器人视觉等。

传感器已经有很多,为何要研发这种传感器?

传感器,并不是新鲜事物。那么研发本传感器的背后原因是什么?

据论文共同通讯作者李远征副教授介绍,当与周围环境互动时,人类的视觉感知能力可以从周围环境中收集到 80% 以上的信息。

视觉感知系统,是人类以及其他脊椎动物最重要的感知系统。作为视觉感知系统的重要组成部分,人眼可以感知颜色、亮度等视觉信息。

此外,人眼可以通过自动调整瞳孔大小,来适应不同的光线强度。比如,人类之所以能在亮光和暗光中都能看清晰图像,正是依赖于这种视觉自适应的能力。

当前,各种模仿生物系统的传感器陆续涌现。其中,仿生视觉传感器已经成为人工智能领域的研究热点之一。在人类的视觉系统之中,一个重要的功能便是视觉适应。

视觉适应,是一种面对刺激时的自主反应。它可以让感知系统调整自身行为,从而适应不同的光线环境。

对于人造类仿生视觉传感器来说,它们往往可以在各种照明条件之下,针对不同刺激响应作出自主调整,从而捕获相关的图像,进而完成视觉检查和视觉识别等任务。

目前,不少仿生视觉传感器都能以动态方式去适应外部光刺激,也就是说它们具备模拟人类视觉适应功能的潜力。

然而,现有的模拟人类视觉适应功能,往往受困于复杂的硬件和软件系统,导致操作效率并不够高。

同时,已有传感器的主要工作机制,仍然局限于对载流子捕获或离子迁移的调控,无法满足视觉自适应器件的应用需求,也无法顺应人工视觉系统的发展趋势。

所以,亟待探索关于传感器的新机制,从而更好地服务于具有简单器件构型的仿生视觉传感器。

也就是说,未来的传感器不仅要拥有传统光传感器的高灵敏响应性能,还要能在特殊环境之下针对所感知的图像进行预处理,从而在确保具有强大预处理功能的同时,也具备大型集成电路所无法达到的超低功耗特点。正是基于这些考虑,课题组研发了本传感器。

传感新技术涌现

这项创新背后还有另一个推动力:堆栈传感器技术的出现。由于之前的传感器大多为传统的背照式传感器,背照式是相对于传统CMOS前照式而言的。传统CMOS在感光元件的感光层前面有一排金属电路,光线要先通过金属排线电路才能到达感光层,这就影响了透光率,甚至造成像素干扰。而背照式传感器的意思就是将这层金属电路层移到了感光层后面以解决上述问题,从而提高光线利用率。传统传感器的结构是在相同的基板上实现像素和电路,为了减小CIS尺寸,必须减少无光面积。但仅实现模拟/数字电路的基本功能,为附加功能添加电路就变得非常有限。

堆栈式传感器是对背照式结构的改进。背照式中的感光层原来也是有电路的并且和后面的电路层相连,堆栈式就是将感光层的像素部分进一步独立出来,将其中的电路层挪至下方替代原有的支持基板,这就进一步提高了感光层的利用率,可以容纳更多的像素,也可以让电路层使用更先进的工艺。“堆栈式传感器技术”,由两个可以独立工作的可见光和近红外图像传感器组成,其中可见光传感器将采用背照式,并配有RGB彩色滤镜。

比如海力士的堆栈传感器,它能够基于先进的半导体工艺,将一个简单的人工智能硬件引擎嵌入到较低的衬底上的ISP中。与此同时,基于机器学习的新技术如超分辨率、颜色恢复、人脸识别和物体识别也在发展中。

这些新型芯片将在一些领域发挥作用,其中一些创新已经开始进入市场。

索尼最近宣布发布两款智能视觉传感器,这是世界上第一个为云服务配备人工智能处理功能的图像传感器。这些产品扩大了开发人工智能摄像头的机会,使零售和工业设备行业的各种应用成为可能,并有助于构建与云连接的最佳系统。

例如,当带有这些传感器的摄像机安装在设施入口处时,它可以计算进入的游客人数。当安装在零售货架上时,它可以检测库存短缺。安装在天花板上,它可以用来绘制游客的热图,以确定人们聚集最多的区域。由于使用基于机器学习的ISP技术,它可以从输入图像中提取和分类各种特征,CIS将成为信息传感器的关键组成部分,用于收集关于图像的各种数据点、位置、距离等生物特征信息。

这对于使用至少10个摄像头来探测周围环境的自动驾驶汽车来说更加重要。为了提高精度,汽车摄像头需要满足各种各样的要求,比如对区分距离物体的高分辨率支持,对即使在黑暗环境中也能识别物体的HDR支持,以及对ISP进行预处理以减少处理器的计算量。

在安全领域,我们需要一个功能来压缩和加密CIS内置ISP中的图像信号,并将其传输到外部处理器。如果将未加密的图像信号按原样发送给外界,则增加了安全漏洞和信息泄露的可能性。因此,CIS内部的加密功能至关重要。

智能手机应用程序在CIS市场份额中处于领先地位,但许多其他应用程序有望成为CIS未来增长的驱动力,特别是随着机器视觉应用程序的增长和演变。这些新出现的机会正在推动技术从移动成像进入其他增长领域,我们可能会看到从使用视觉成像到使用视觉传感和其他交互应用的转变。

仿生眼技术迭代20余年,或成人形机器人标准模块

李嘉茂团队关于仿生眼的研究始于20世纪90年代。他的导师张晓林(实验室创始主任)在1999年做出第一代仿生眼,主要实现了双眼协调控制,从当时拍摄的照片中可以看到,双眼中间有一根明显的转动轴。

当时电脑还很笨重,算力也比较小,一双仿生眼要靠两台电脑控制。一台电脑做视觉采集和计算,另外一台电脑用来实现电机控制,两台电脑堆起来的高度接近2米。

随着机械、视觉传感器、芯片等技术进步,仿生眼的外形越来越逼真,“视力”越来越清晰,功能也越来越多。第二代具备扫视、跟踪、稳向等多种眼球运动能力;第三代实现立体视觉,有一定的计算能力了,但还是在大脑初级视觉的范畴;第四代实现语义理解,可以认知场景,能够进行视觉导航了;第五代更多是结构上的变化,大小实现了跟人眼一样的2厘米直径,在形态上更加仿真拟人。

李嘉茂介绍,团队正在推进视觉与听觉、与四肢协同方面的探索,包括研发机器人的脑干芯片。“机器人有很多传感器,传感器之间的同步对于机器人高精度控制来说非常重要。脑干芯片就是把机器人的多种传感器融合起来,就像人的脑干一样做视觉、听觉、触觉等多种信息的融合,同时集成处理器、微处理器、神经网络处理器,为机器人提供脑干以及部分大脑的功能。”他说。

展望仿生眼接下来的发展,李嘉茂认为,它很可能成为人形机器人的标准模块。“现在,人形机器人的四肢和躯干基本做到跟人的形态一致了,但还缺少一双‘眼睛’。随着视觉传感性能的进一步优化,仿生眼能让机器人跟人接触时产生互动,在情感表达上效果更好。”

记者在交流中发现,仿生眼的学科交叉属性非常强,高度依赖基础技术,机械、生物、计算机都包含其中。机缘巧合的是,目前仍是实验室首席科学家的张晓林在攻读博士学位期间学习的是机械控制,毕业后进入医科大学开始研究与神经相关的眼球运动控制。李嘉茂学计算机出身,因为对机器人感兴趣,在2005年读研究生时选择了机器人方向,当时机器人和人工智能还比较冷门。交叉学科的学习经历让他们成为仿生人眼视觉领域研究的先行者,见证了仿生眼的迭代进步。

采访的最后,李嘉茂告诉记者,他非常期待人形机器人研究的新突破,具体到仿生眼,他关注四方面技术能力的提升:

一是更强大的后端知识与算力平台,仿生眼属于前端智能,与后端知识与算力平台结合将互相赋能,形成信息采集与智能运算的强强联合;

二是芯片算力的提升,智能算法需要消耗很大的算力,仿生眼算法的提高跟算力的提升不可分割;

三是视觉传感器分辨率的提升,视觉传感器的分辨率近年来飞速提升,但依旧不如人眼;

四是人工肌肉,仿生眼现在是利用电机驱动,如果人工肌肉等更柔性的材料取得突破,将助力仿生眼的控制更高精度、体积更小型化。

李嘉茂介绍,从20多年前用两台笨重的电脑控制仿生眼运动,到现在一个指甲盖大小的芯片就能实现大部分功能,团队的仿生眼相关技术已在地铁弓网检测、芯片制造自动化等领域应用,在仿生人眼视觉领域实现了国际一流。“更令人期待的是促进人形机器人迭代,仿生眼未来很可能成为人形机器人的一个标准模块。”