出品 | 虎嗅科技组

作者 | 丸都山

编辑 | 陈伊凡

头图 | 视觉中国

生成式AI的风口下,一些行业正在“闷声发大财”。

从今年2月开始,中国台湾厂商AVC和双鸿(AURAS)股价一路飙升,在端午假期前的最后一个交易日,两家公司的股价较4个月前均实现翻倍,分别收报249.5新台币(约合58.1元人民币)及292.5新台币(约合68.1人民币)。

如果对照芯片巨头英伟达(NVEDIA)近期股价走势,会发现三者之间存在着惊人的一致性——这家芯片巨头公司同样在这4个月里实现了股价翻倍。

这显然不是巧合。

实际上,上述两家位于中国台湾地区的公司,或多或少与英伟达有关,确切地说是与生成式AI相关。AVC是全球最大散热模组厂商,也是英伟达AI服务器系统DGX H100目前的风冷散热系统供应商,双鸿则是Supermicro(超微电脑)服务器散热系统的供应商。

散热,这个过去不被人们重点关注的产业,正由于AI带来的数据量和计算量的爆发增长逐渐从幕后走向台前,多位从业人士向虎嗅表达了这样一个观点:“今明两年,AI行业中可能会出现算力被散热‘卡脖子’的情况。”

6月15日,在AMD发布APU(加速处理器)MI 300系列后,AMD股价由于受到“缺少大客户”的质疑下跌3.6%,但就在同一日,AVC与双鸿的股价却因AI芯片出现新玩家的利好应声上涨5.8%和3.6%。

作为一个与计算机科学共同成长起来的产业,散热模组厂商们经历了多次电子信息革命,但当下AI的爆发,似乎才真正让这个行业真实现了“翻身”。

AI的尽头是散热?

当电流通过电阻时,所消耗的电能会全部转化为热能,这种现象被称为电流的热效应,自计算机诞生以来,从业者们用尽办法将电子器件的温度控制在合理的范围内。

当然,早期的计算机功耗较低,而且整机体积较大,因此不需要单独设计系统级的散热解决方案,通常做法就是在计算机背部放置个简易的风扇,以将热流导出。

1989年,英特尔发布了80486处理器,人类第一次实现了在微处理器中集成百万级晶体管,这枚芯片的功耗也水涨船高,在芯片出厂时,英特尔为其配备了一组铝制的散热片,再配合机箱上的风扇完成整体散热。

以今天的视角来看,这种方案还是很简陋,但它勾勒出了散热设计最底层的原理:先导热,再散热。简单地来说,导热就是将热量在介质中传送,散热就是让热量尽可能快地从介质向外界散发。

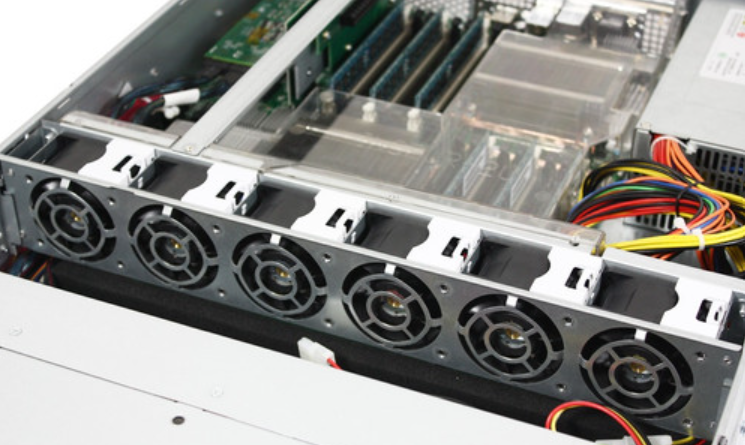

传统的服务器散热方案与计算机散热原理大致相同,区别在于服务器所使用的算力芯片由于能耗较高,往往将芯片级散热系统作为重点,通常来说就是将芯片热量通过热管、均热片等传导到多褶结构的散热鳍片上,再通过风扇进行主动散热。

传统服务器散热器,与台式机基本一致。图片来源:中关村在线

不过,这种风冷式散热方案在当前AI服务器上的表现已经明显力不从心。

原因在于高性能AI芯片的功耗在随着算力同步大幅提升。10年前市面上能买到的最顶级的数据中心GPU是英伟达K40,其热设计功耗(TDP)为235W,2020年英伟达发布A100时,热设计功耗接近400W,到了最新的H100芯片,热设计功耗直接飙升到700W。

国内散热技术厂商广州力及热管理科技(NeoGene Tech)创始人陈振贤向虎嗅表示,到了明年,单颗高性能AI芯片的热设计功耗将会突破1000W。

那么风冷式散热对应的散热极限是多少?国金证券研究所的一份报告指出,服务器2U空间下,250W大约是风冷的极限,4U以上空间风冷可以解到400W-600W。

这里需要普及下“U”的概念,这是美国电子工业协会制订的标准化尺寸,1U服务器的宽度为48.26厘米(19英寸),高度为4.445厘米(1.75英寸)。通常情况下,标准服务器机柜的高度为42U,但这并不意味可以容纳42枚1U服务器,因为过大的密度会增加散热负担。

而如果使用英伟达H100芯片的话,在使用风冷散热模组方案的情况下,就需要用到4U的机柜。

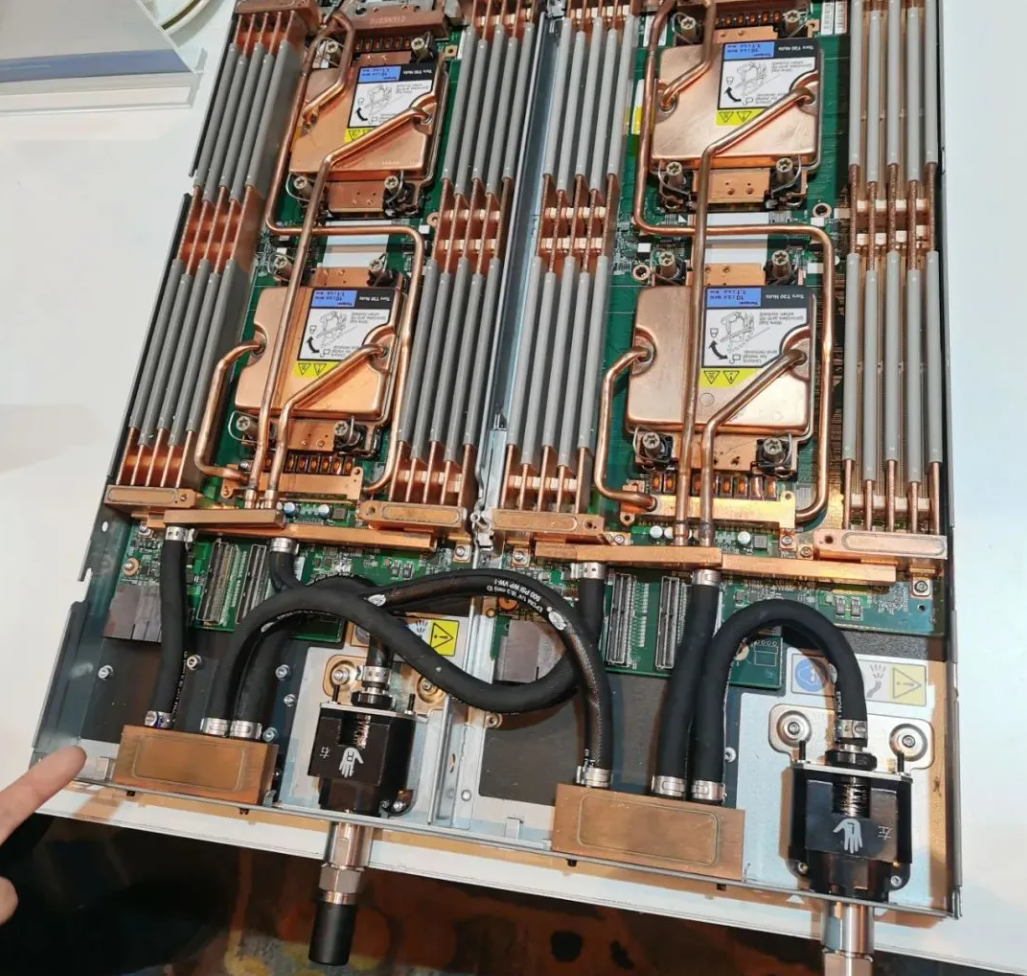

因此,为了提高单一机柜的功率密度,数据中心近些年开始普遍使用液冷方案。其大致可以分为两种技术路径:冷板式(Cold Plate)与浸没式(Immersion),前者是通过冷板将发热器件的热量间接传递给封闭在循环管路中的冷却液体,后者则直接将发热器件以及电路板整体直接置于液体中。与空气介质相比,液体的导热率更高、比热容更大、吸热能力也更强。

1U 2x双路节点服务器的冷板式散热方案,图片来源:@企业存储技术

另外在运营成本上,液冷散热也有较大的优势。传统风冷散热将服务器芯片热量吹到数据中心机房内,这要求机房空调温度必须大幅降低,一位业内人士向虎嗅透露,台积电的数据中心温度常年维持在零度左右。而液冷散热模组的设备虽然较为昂贵,但大多属于一次性成本,后续的能耗成本可以大幅降低。

但这并不意味着目前液冷散热技术就是一种万全之策,陈振贤指出,在现有要求降低PUE(指数据中心消耗的所有能源与IT负载消耗的能源的比值)的限制下,既有的冷板式及浸没式液冷技术也都纷纷面临着解热极限的问题。

中科创星董事总经理卢小保也向虎嗅表示,目前无论是风冷还是液冷散热方案,都进入明显的发展瓶颈期,未来热管理相关技术可能会成为AI芯片性能释放的决定性限制因素。

破局点在哪里?

尽管业内目前还没有出现公认的“最佳解决方案”,但市场对于AI服务器的需求不会因此陷入停滞。

第三方研究机构TrendForce发布的预测指出,2023年AI服务器(包含GPU、FPGA、ASIC等主芯片)出货量将接近120万台,同比去年增长38.4%,而AI芯片今年出货量将增长46%。

有业内人士向虎嗅表示,在今年的AI服务器市场中,英伟达A100与A800的出货量将可能会占据80%,而随着下半年数据中心陆续导入热设计功耗高达700W的H100芯片后,行业内既有的散热技术可能都需要进行一次“推倒重建”。

卢小保认为,传统的风冷式散热方案并不是完全没有开发空间,但前提是导热器件必须进行升级换代,比如引入环路热管技术。

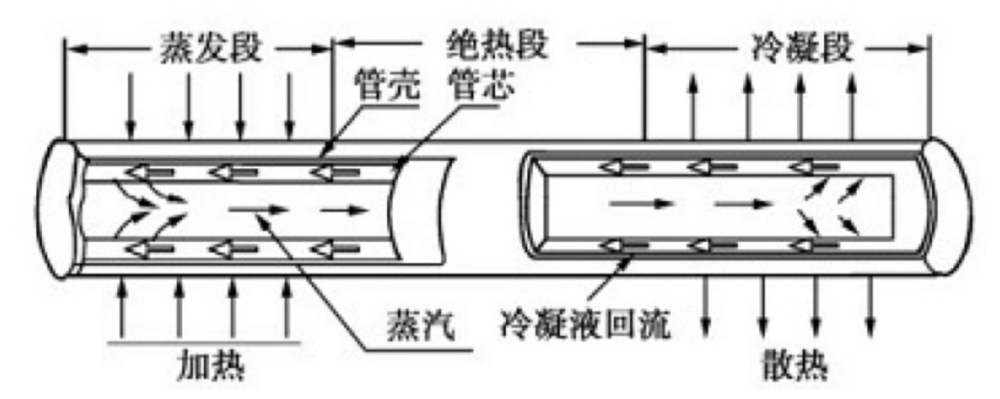

目前芯片级风冷散热模组中,导热器件主要以热管为主,它的主体是一根封闭、中空的金属管,内部有少量工作介质(主要是纯水)的毛细结构,运行时依靠介质蒸发吸收芯片热量,再由风扇将热量吹走。

热管工作原理,图片来源:antpedia

而环路热管在保留上述特性的同时,导热能力增加几倍,而且导热距离更大,可以传递到一米以外甚至理论上可以传导到十几米以外,这是该技术在卫星上已经实现的效果。

“如果环路热管能做到数米远,就意味着可以直接将服务器芯片的热量导出到数据中心外部,连机房温度的问题都解决了”,卢小保指出。

不过作为一种航天工程的衍生技术,要在地面环境下落地应用,技术难度极高,虽然学术界和工业界都有很多团队在从事这项技术的研发,但真正具备落地商用能力的极少。

同样,液冷散热方案也具备升级迭代的潜力。比如结合将冷板与浸没式散热的技术特点相结合,在传统的1U或2U机柜槽中接入冷板,再接入浸没散热用的单向冷却液,以实现双重冷却循环。

据外媒Electronics Weekly报道,前不久美国能源部(DOE)立项了一个名为COOLERCHIPS的研究计划,䃼助英伟达5百万美元开发此项混合液冷技术,利用两相冷却液作为冷板的内循环,非导电冷却液体则是被直接注入服务器中做循环。

陈振贤表示,NeoGene Tech亦自主研发了一种更先进的具有三重液冷循环之服务器装置技术,将具备更高功率芯片的散热及散热能力,而且无需价格昂贵的两相冷却液作为循环,在运营成本上将更优。

此外,NeoGene Tech还基于冷板式液冷技术开发了一种被称为牛劲冷泵(NeoGene Liquid Cooler)液冷散热器产品,整体高度已经压缩至24.5mm,可以满足数据中心1U服务器机柜的超高密度布建需求。其最大特点是可通过内部三维蒸气腔的功能设计,根据芯片功率及功率密度做出解热及散热的功能调整。

陈振贤指出,1U的牛劲冷泵液冷散热器已经可以服务TDP超过1000W的高算力芯片。

1U规格的牛劲冷泵液冷散热产品,图片来源:NeoGene Tech

以上提到的技术方案,都是基于过去散热模组的迭代,那么是否存在一种技术,可以直接在芯片上做文章?

在今年3月,NeoGene Tech曾公开了一个针对高功率芯片封装的散热方案:直接将裸芯片和牛劲冷泵液冷循环系统封装在一起工作。

陈振贤向虎嗅表示,“在这个技术路径下,散热模组不再是芯片外部的独立器件,它本身就是IC元件的一部分,可达到即插即用(Plug&Play)的目的”。

这项散热封装技术若再搭配具有三重液冷循环之服务器装置技术,能够为数据中心省去所有的二级、三级散热系统,只需将自我浸没式服务器插入机柜内, 再接入水管及非导电冷却液管就可以直接使用。当然,该方案对先进封装工艺有一定的要求。

另一种直接在芯片上做散热的技术,也与封装工艺紧密结合,那就是Chiplet。

简单地来说,就是将一个单颗SoC芯片的功能拆分成众多小芯片,然后运用先进封装技术重组成一个庞大复杂的系统。从芯片散热的角度来说,Chiplet不会使芯片整体功率降低,但在拆分后的表面积会增加,也就是说同等热设计功率下,单位面积内热流强度会降低。

从这里也可以看出一个趋势,那就是在AI芯片算力与能耗大幅提升的背景下,芯片散热问题,或者说热管理问题,已经不再是一个独立的学科,而是更加趋近于系统性工程,未来AI芯片的天花板,或许真的取决于散热技术的发展水平。

Tips:我是虎嗅前沿科技组张晋源,关注消费电子、半导体及元宇宙相关行业,欢迎交流(请务必备注商业身份,谢谢。微信:18510113471)。